Aprendizado de Máquina

Prof. Ronaldo Cristiano Prati

ronaldo.prati@ufabc.edu.br

Bloco A, Sala 513-2

Classificação

- Um outro problema dentro de aprendizado supervisionado é a classificação

- y é discreto:

- e-mail: SPAM/não SPAM?

- transções online: fraudulenta/normal?

- tumor: maligno/benigno?

- y é discreto:

- vamos começar com um problema de classificação binária (veremos multiclasse depois)

Classificação

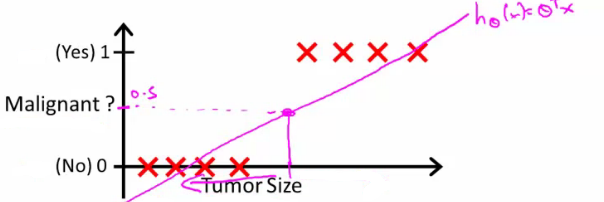

- Podemos usar regressão linear?

- y pode ser representado como 0 ou 1:

- 0: classe negativa

- 1: classe positiva

- Um ponto de corte no valor predito (p.ex. acima de 0.5), é classificado como classe positiva

Classificação

- E se tivermos poucos exemplos da classe 1? Provavelmente a inclinação da reta seria menor, e classificaríamos tudo com classe 0.

- Nossa hipótese também prediz valores abaixo de 0 e acima de 1, apesar da classe só poder assumir os valores 0 e 1.

- Regressão logística pode contornar esses problemas

Regressão logística

- Apesar de se chamar regressão, é um algoritmo de classificação

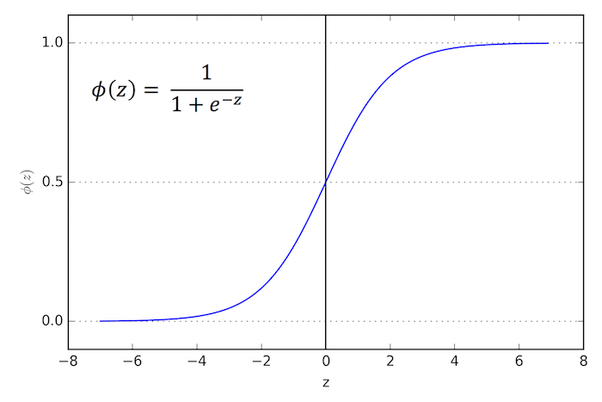

- A hipótese tem a forma de htheta(x)=g((θ⊺x)), em que:

g(z)=1+e−z1 - Essa é a função sigmoid ou função logística

- Podemos reescrever htheta(x) como

hθ(z)=1+e−θ⊺x1

Regressão logística

Interpretando a saída

- A hipótese hθ(x) dá como saída um número entre 0 e 1 que pode ser interpretada como a probabilidade que y=1 para a entrada x

- Por exemplo, se hθ(x)=0.7 para um certo xi, o modelo dá 70% de chance de um tumor malígno

- Em outras palavras, hθ(x)=P(y=1∣x,θ)

- Como o problema é binário, temos que:

P(y=1∣x,θ)+P(y=0∣x,θ)=1P(y=0∣x,θ)=1−P(y=1∣x,θ)

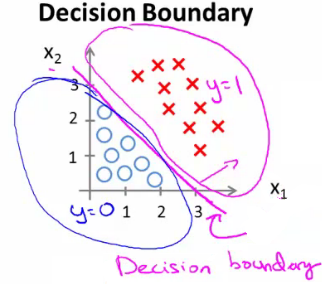

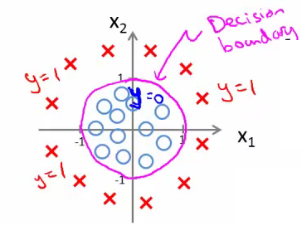

Fronteira de decisão

- Para predizer a classe, utilizamos aquela com maior probabilidade, segundo o modelo

- Isso é equivalente a predizer a classe 1 se hθ(x)>0.5, e a classe 0 caso contrário

- Observando a função logística, temos que hθ(x)=0.5 quando z=0.

- Como z=θ⊺x, a linha θ⊺x=0 é a fronteira de decisão entre as duas classes

θ⊺x>0: predizer classe 1

θ⊺xleq0: predizer classe 0

Fronteira de decisão

- A linha em que hθ(x)=0.5 (ou que θ⊺x=0) é a fronteira de decisão.

Fronteira de decisão não linear

-

Se adicionarmos novos atributos que fazem uma transformação não linear nos dados (como na aula passada, em que fizemos regressão polinomial adicionando atributos do tipo xk)

-

Por exemplo, se adicionarmos atributos quadráticos, podemos ter fronteiras de decisão do tipo

função de custo para regressão logística

- Nossa hipótese é

hθ(z)=1+e−θ⊺x1 - Na regressão linear temos que

J(θ)=m1i∑mCost(hθ(x),y)

Em que o custo é definido como:

Cost(hθ(x),y)=21(hθ(x)−y)2

função de custo para regressão logística

- Podemos usar a mesma função de custo para regressão logistica?

- Essa função de custo é não convexa (a função da nosso hipótese (sigmoid) é não linear)

- Ao tentar miniminar, podemos ter muitos mínimos locais

- O algoritmo da descida do gradiente pode não encontrar os melhores valores para θ

- Temos uma função convexa para por no lugar?

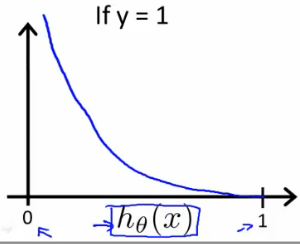

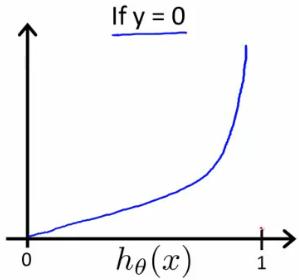

função de custo para regressão logística

- Uma função de custo convexa:

Cost(hθ(x),y)={−log(hθ(x))−log(1−hθ(x))sey=1sey=0

função de custo para regressão logística

função de custo para regressão logística

- Como só temos duas classes, podemos escrever a função de custo de uma maneira mais compacta:

Cost(hθ(x),y)=−ylog(hθ(x))−(1−y)log(1−hθ(x))

- Essa função pode ser derivada da estatística, usando o princípio da estimação da máxima verossimilhança

- Assume que existe uma distribuição Gaussiana dos atributos

- É convexa

Gradiente descendente para regressão logistica

- Podemos usar o gradiente descendente para encontrar θ na regressão logística

θ:=θ−αi∑m(hθ(xi)−yi)xi

-

Essa equação é a mesma da regressão linear

- A única diferença é que agora usamos uma hipótese diferente

-

Colocar os atributos na mesma escala também pode ser necessário

Além do gradiente descendente

-

Existem outras possíveis maneiras de minizar a função de custo

-

São algoritmos mais complexos e otimizados, que podem ser aplicados à mesma entrada e função de custo

Além do gradiente descendente

- Vantagens:

- Não precisamos ajustar α (taxa de aprendizado) manualmente

- Testam vários α internamente para escolher o mais adequado (além de outras melhorias)

- Em geral, mais rápidos que o gradiente descendente

- Desvantagens

- Difícil "acompanhamento"

- Difícil implementação

- Diferentes bibliotecas usam diferentes otimizações (desempenho diferente)

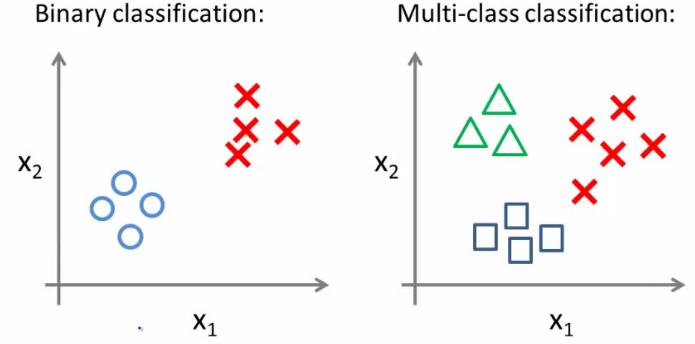

Regressão logística multiclasse

- Poblemas multiclasse: mais de duas classes

Regressão logística multiclasse

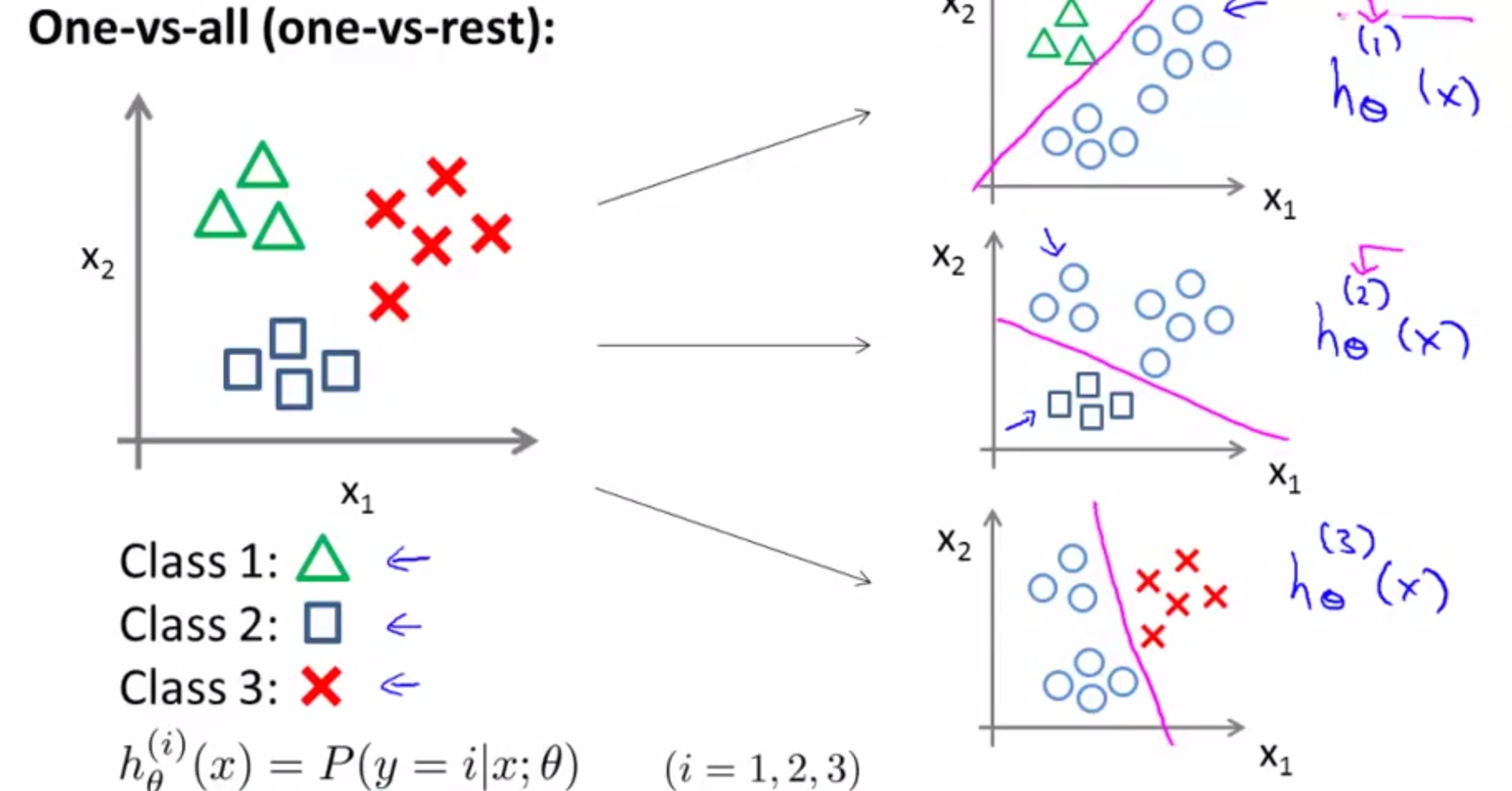

- Estratégia "um contra todos" (one-versus-all ou one-versus-rest)

- Dividir o conjunto de dados em diversos problemas de classificação (igual ao número de classes)

- Em cada problema, uma das classes é a positiva, e as demais são agrupadas na negativa

- Escolher a classe que maximiza P(y=1∣xk;θ), em que k é a classe positiva no problema de classificação k

Regressão logística multiclasse